News Telegraf

-

![Гороскоп на сегодня для всех знаков Зодиака — 20 февраля 2026]()

Гороскоп на сегодня советует знакам Зодиака полагаться не на магию, а на личные ощущения

-

![Скидки в АТБ]()

Кофе, мороженое, рыба и бытовая химия – что сейчас в магазине дешевле

-

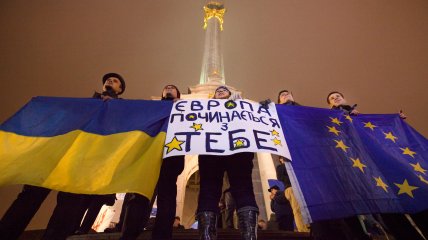

![Митинги у стелы]()

Важнейшие поступки смелых людей, изменивших страну

-

![Отключения света]()

В течение суток применяются отключения для нескольких очередей одновременно

-

![Что известно об отключениях света в Киеве]()

Ограничения применяют из-за повреждений энергообъектов в ходе российских атак

-

![Иллюстративное фото]()

Дети сбегались к нему со всего города, он пережил бомбардировки Второй мировой, а однажды просто исчез

-

![Что нельзя хранить дома]()

За черной полосой никак не наступит светлая? Оглянитесь вокруг себя, есть вещи, которые никогда (!) не позволят быть счастливыми.

-

![Иллюстративное фото]()

Ответ оказался неожиданным: дело не только в расстояниях, но и в возрасте Вселенной, ее расширении и особенностях человеческого зрения

-

![Иллюстративное фото]()

Есть города, рассказывающие о себе еще до того, как ты до них доедешь

-

![Иллюстративное фото]()

Пять веков эта площадь на Подоле была торговой площадью, идеологическим символом и местом народной памяти.

-

![Иллюстративное фото]()

Она похожа на бриллиант, покрытая 23-каратным золотом и доставляемая с охраной — как ювелирное изделие.

-

![Медали Олимпийских игр-2026 в Италии]()

Полный медальный зачет Олимпийских игр в Милане и Кортина-д’Ампеццо

-

![Веник]()

Этот день — напоминание о важности добрых дел и милосердии

-

![Олимпийские игры]()

На Играх стартовал новый вид спорта

-

![Коллаж "Телеграф"]()

Из-за энергетического террора России украинцы вынуждены жить в условиях постоянных отключений света. Так что в пятницу, 20 февраля, в течение всего дня в стране есть отключение электричества для бытовых потребителей, сообщает "Укрэнерго"